MATLAB、Python、Scilab、Julia比較ページはこちら

https://www.simulationroom999.com/blog/comparison-of-matlab-python-scilab/

はじめに

の、

MATLAB,Python,Scilab,Julia比較 第4章 その110【最適化アルゴリズム⑨】

を書き直したもの。

Adamに至るまでの最適化アルゴリズムの系譜とそれらの依存関係とプログラムで実現する準備まで完了。

これを今回Scilabで実現する。

Adamの更新式【再掲】

まずはAdamの更新式を再掲。

\(

\begin{eqnarray}

m_{t+1}&=&\beta_1 m_{t-1}+(1-\beta_1)\nabla J(\theta_t)\\

v_{t+1}&=&\beta_2 v_{t-1}+(1-\beta_2)(\nabla J(\theta_t))^2\\

\displaystyle\hat{m}_{t+1}&=&\frac{m_{t+1}}{1-\beta_1}\\

\displaystyle\hat{v}_{t+1}&=&\frac{v_{t+1}}{1-\beta_2}\\

\displaystyle\theta_{t+1}&=&\theta_t-\frac{\alpha}{\sqrt{\hat{v}_{t+1}}+\epsilon}\\

m_t&:&1次のモーメント\\

v_t&:&2次のモーメント\\

\hat{m}_t,\hat{v}_t&:&バイアス補正項\\

\beta_1,\beta_2&:&指数移動平均係数(\beta_1=0.9,\beta_2=0.999)

\end{eqnarray}

\)

これを今回はScilabで実現する。

Scilabコード

Scilabコードは以下。

// シグモイド関数の定義

function y = sigmoid(x)

y = 1 ./ (1 + exp(-x));

endfunction

// シグモイド関数の導関数の定義

function y = sigmoid_derivative(x)

y = sigmoid(x) .* (1 - sigmoid(x));

endfunction

// データの準備

X = [0 0; 0 1; 1 0; 1 1]; // 入力データ

Y = [0; 1; 1; 0]; // 出力データ

// ネットワークの構築

hidden_size = 4; // 隠れ層のユニット数

output_size = 1; // 出力層のユニット数

learning_rate = 0.001; // 学習率

input_size = size(X, 2);

W1 = rand(input_size, hidden_size, 'normal'); // 入力層から隠れ層への重み行列

b1 = rand(1, hidden_size, 'normal'); // 隠れ層のバイアス項

W2 = rand(hidden_size, output_size, 'normal'); // 隠れ層から出力層への重み行列

b2 = rand(1, output_size, 'normal'); // 出力層のバイアス項

// Adamのハイパーパラメータの設定

beta1 = 0.9; // モーメンタムの指数減衰率

beta2 = 0.999; // 2次モーメントの指数減衰率

epsilon = 1e-8; // 数値安定性のための小さな値

// Adam用の変数の初期化

mW1 = zeros(W1);

mb1 = zeros(b1);

mW2 = zeros(W2);

mb2 = zeros(b2);

vW1 = zeros(W1);

vb1 = zeros(b1);

vW2 = zeros(W2);

vb2 = zeros(b2);

// 学習

epochs = 20000; // エポック数

errors = zeros(epochs, 1); // エポックごとの誤差を保存する配列

for epoch = 1:epochs

// 順伝播

Z1 = X * W1 + ones(size(X, 1),1) * b1; // 隠れ層の入力

A1 = sigmoid(Z1); // 隠れ層の出力

Z2 = A1 * W2 + b2; // 出力層の入力

A2 = sigmoid(Z2); // 出力層の出力

// 誤差計算(平均二乗誤差)

error = (1/size(X, 1)) * sum((A2 - Y).^2);

errors(epoch) = error;

// 逆伝播

delta2 = (A2 - Y) .* sigmoid_derivative(Z2);

delta1 = (delta2 * W2') .* sigmoid_derivative(Z1);

grad_W2 = A1' * delta2;

grad_b2 = sum(delta2);

grad_W1 = X' * delta1;

grad_b1 = sum(delta1);

// パラメータの更新

gt_W1 = grad_W1;

gt_b1 = grad_b1;

gt_W2 = grad_W2;

gt_b2 = grad_b2;

mW1 = beta1 * mW1 + (1 - beta1) * gt_W1;

mb1 = beta1 * mb1 + (1 - beta1) * gt_b1;

mW2 = beta1 * mW2 + (1 - beta1) * gt_W2;

mb2 = beta1 * mb2 + (1 - beta1) * gt_b2;

vW1 = beta2 * vW1 + (1 - beta2) * (gt_W1 .^ 2);

vb1 = beta2 * vb1 + (1 - beta2) * (gt_b1 .^ 2);

vW2 = beta2 * vW2 + (1 - beta2) * (gt_W2 .^ 2);

vb2 = beta2 * vb2 + (1 - beta2) * (gt_b2 .^ 2);

mHatW1 = mW1 / (1 - beta1);

mHatb1 = mb1 / (1 - beta1);

mHatW2 = mW2 / (1 - beta1);

mHatb2 = mb2 / (1 - beta1);

vHatW1 = vW1 / (1 - beta2);

vHatb1 = vb1 / (1 - beta2);

vHatW2 = vW2 / (1 - beta2);

vHatb2 = vb2 / (1 - beta2);

W1 = W1 - learning_rate * mHatW1 ./ (sqrt(vHatW1) + epsilon);

b1 = b1 - learning_rate * mHatb1 ./ (sqrt(vHatb1) + epsilon);

W2 = W2 - learning_rate * mHatW2 ./ (sqrt(vHatW2) + epsilon);

b2 = b2 - learning_rate * mHatb2 ./ (sqrt(vHatb2) + epsilon);

end

// 決定境界線の表示

h = 0.01; // メッシュの間隔

[x1, x2] = meshgrid(min(X(:, 1)) - 0.5:h:max(X(:, 1)) + 0.5, min(X(:, 2)) - 0.5:h:max(X(:, 2)) + 0.5);

X_mesh = [x1(:) x2(:)];

hidden_layer_mesh = sigmoid(X_mesh * W1 + ones(size(X_mesh, 1), 1) * b1);

output_layer_mesh = sigmoid(hidden_layer_mesh * W2 + b2);

y_mesh = round(output_layer_mesh); // 出力を0または1に丸める

clf;

x = X_mesh(:, 1);

y = X_mesh(:, 2);

idx_boundary = find(y_mesh(1:$-1) <> y_mesh(2:$)); // 境界のインデックスを取得

boundary_x = x(idx_boundary); // 境界のx座標

boundary_y = y(idx_boundary); // 境界のy座標

scatter(boundary_x, boundary_y, 3, 'k', 'fill'); // 境界を黒でプロット

scatter(X(Y==0, 1), X(Y==0, 2), 100, 'r', 'fill');

scatter(X(Y==1, 1), X(Y==1, 2), 100, 'b', 'fill');

xlabel("X1");

ylabel("X2");

title("XOR Classification");

legend("Boundary", "Class 1", "Class 0");

xgrid; // グリッドの表示

figure;

plot(errors);

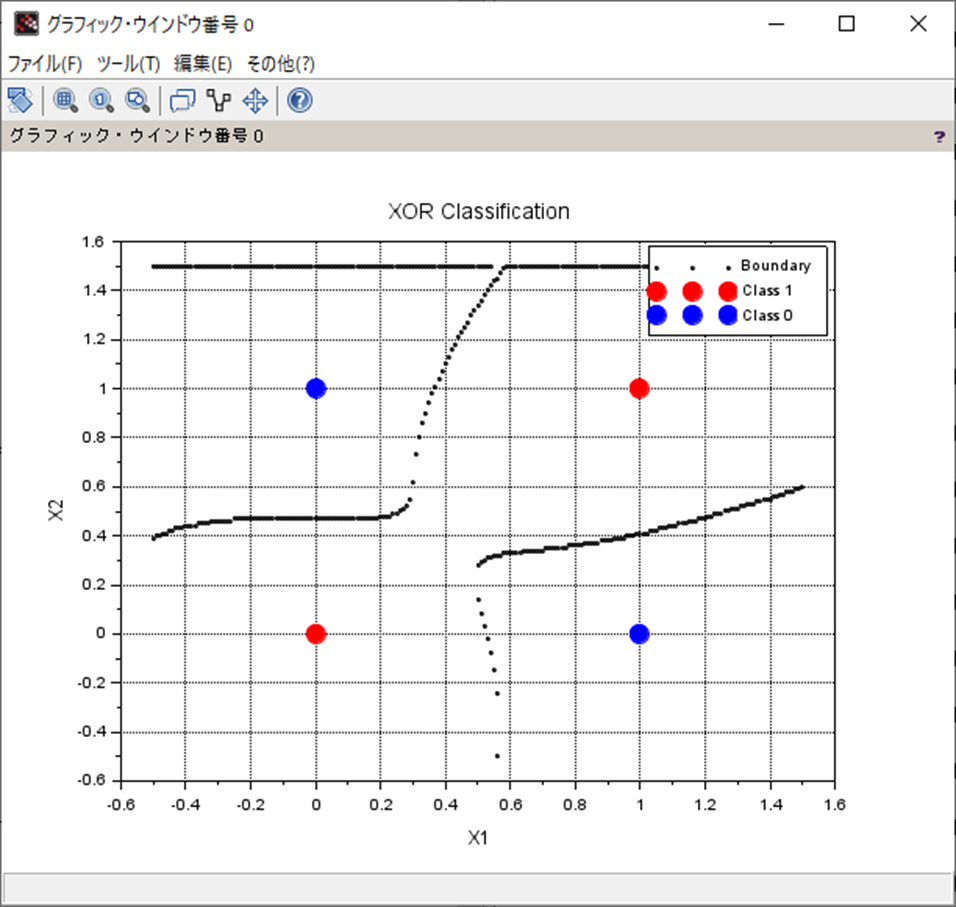

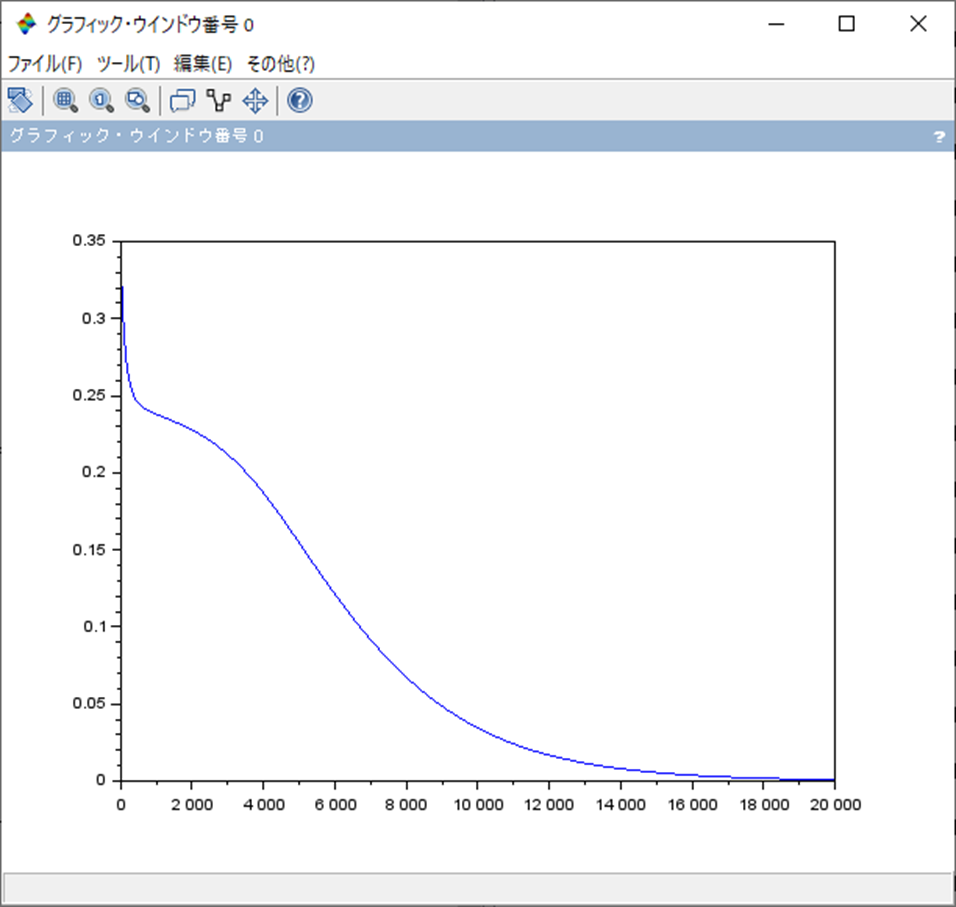

処理結果

処理結果は以下となる。

まとめ

- ニューラルネットワークの最適化アルゴリズムAdamをScilabにて確認。

- 学習率を0.001にしている都合、収束までは時間がかかる。

- 勾配降下法、モーメンタムでは見れなかった分類パターンが拾えた。

MATLAB、Python、Scilab、Julia比較ページはこちら

Pythonで動かして学ぶ!あたらしい線形代数の教科書

ゼロから作るDeep Learning ―Pythonで学ぶディープラーニングの理論と実装

ゼロからはじめるPID制御

OpenCVによる画像処理入門

恋する統計学[回帰分析入門(多変量解析1)] 恋する統計学[記述統計入門]

Pythonによる制御工学入門

理工系のための数学入門 ―微分方程式・ラプラス変換・フーリエ解析

コメント