バックナンバーはこちら。

https://www.simulationroom999.com/blog/compare-matlabpythonscilabjulia4-backnumber/

はじめに

多層パーセプトロンの誤差逆伝播法について。

今回は、「出力層の重みとバイアスを求める誤差からの連鎖律」を確認する。

登場人物

博識フクロウのフクさん

イラストACにて公開の「kino_k」さんのイラストを使用しています。

https://www.ac-illust.com/main/profile.php?id=iKciwKA9&area=1

エンジニア歴8年の太郎くん

イラストACにて公開の「しのみ」さんのイラストを使用しています。

https://www.ac-illust.com/main/profile.php?id=uCKphAW2&area=1

多層パーセプトロンの誤差逆伝播法の説明の流れ【再掲】

まずは、多層パーセプトロンの誤差逆伝播法の説明の流れを再掲。

- 誤差逆伝播法の全体像の確認(済)

- 出力層の重みとバイアスを求める誤差からの連鎖律

- 隠れ層の重みとバイアスを求める誤差からの連鎖律

- 上記をプログラミングするための最適化

今回は、「出力層の重みとバイアスを求める誤差からの連鎖律」を確認する。

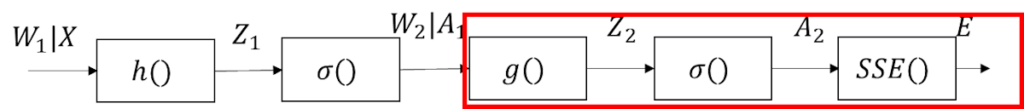

出力層の合成関数

まず、全体の合成関数から出力層の合成関数の位置を確認。

以下に図示する。

そして、前回も記載したが出力層で見た合成関数は以下になる。

\(

{\rm{SSE}}(\sigma(g(A_1,W_2)))

\)

これの導関数を連鎖律で求めればよいわけか。

そうそう。

出力層の連鎖律

誤差\(E\)を出力層の重み\(W_2\)で微分するにあたって、

間に\(A_2,Z_2\)が居るので、連鎖律は以下になる。

\(

\displaystyle\frac{\partial E}{\partial W_2}=\frac{\partial E}{\partial A_2}\frac{\partial A_2}{\partial Z_2}\frac{\partial Z_2}{\partial W_2}

\)

それぞれの偏微分を求める。

\(

\displaystyle\frac{\partial E}{\partial A_2}=\frac{1}{2}(A_2-Y)^2=A_2=Y

\)

\(

\displaystyle\frac{\partial A_2}{\partial Z_2}=\sigma^\prime(Z_2)

\)

\(

\displaystyle\frac{\partial Z_2}{\partial W_2}=(W_2 A_2 + b_2)^\prime=A_2

\)

連鎖律として組み合わせる。

\(

\displaystyle\frac{\partial E}{\partial W_2}=(A-Y)\sigma^\prime(Z_2)A_1

\)

ちなみに、バイアスの方は途中過程は省略するが以下になる。

\(

\displaystyle\frac{\partial E}{\partial W_2}=(A-Y)\sigma^\prime(Z_2)

\)

連鎖律を把握してると結構簡単に求められるね。

多層であるが故の注意点

ここで注意点がある。

先ほどの出力層の連鎖律に出てくる\(A_1,Z_2\)だが、定数というわけではない。

これは多層パーセプトロンへの入力に依存して決まるもの。

そうすると具体的な数値が求められないんじゃ・・・。

そのために事前に順伝播を行う。

この順伝播時の\(A_1,Z_2\)を記憶しておけばOKだ。

なんだ、それだけか。

多層であるが故に追加で記憶しておくパラメータってことになるな。

まとめ

まとめだよ。

- 出力層の合成関数を確認。

- 出力層の連鎖律と各偏導関数を導出。

- 多層であるが故に、順伝播時の中間変数を記憶しておく必要がある。

バックナンバーはこちら。

Pythonで動かして学ぶ!あたらしい線形代数の教科書

ゼロから作るDeep Learning ―Pythonで学ぶディープラーニングの理論と実装

ゼロからはじめるPID制御

OpenCVによる画像処理入門

恋する統計学[回帰分析入門(多変量解析1)] 恋する統計学[記述統計入門]

Pythonによる制御工学入門

理工系のための数学入門 ―微分方程式・ラプラス変換・フーリエ解析

コメント