MATLAB、Python、Scilab、Julia比較ページはこちら

https://www.simulationroom999.com/blog/comparison-of-matlab-python-scilab/

はじめに

の、

MATLAB,Python,Scilab,Julia比較 第4章 その24【シグモイドによる決定境界安定化④】

を書き直したもの。

活性化関数をシグモイド関数にした形式ニューロンをPython(NumPy)で実現

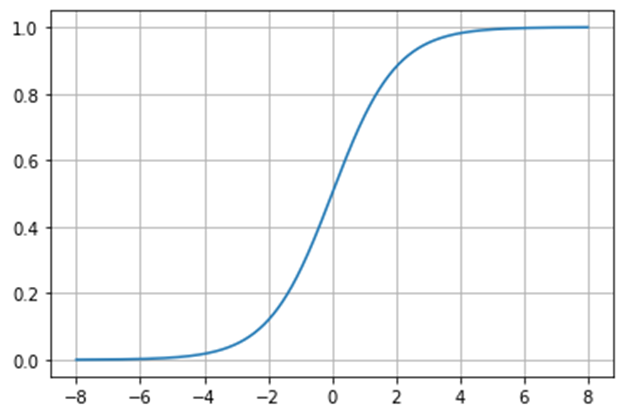

【再掲】シグモイド関数

差し替えるシグモイド関数の数式と波形は以下になる。

\(

\displaystyle\varsigma=\frac{1}{1+e^{-ax}}=\frac{tanh(ax/2)+1}{2}

\)

これを活性化関数とした形式ニューロンをPython(NumPy)で実現する。

Pythonコード

Pythonコードは以下

import numpy as np

import matplotlib.pyplot as plt

def sigmoid(x):

return 1 / (1 + np.exp(-x))

# データセットの入力

X = np.array([[0, 0], [0, 1.0], [1.0, 0], [1.0, 1.0]])

# データセットの出力

Y = np.array([0, 0, 0, 1])

# パラメータの初期値

W = np.zeros((2, 1)) # 重み

b = 0 # バイアス

num_epochs = 10000 # 学習のエポック数

learning_rate = 0.1 # 学習率

min_loss = float('inf')

learning_range = 4

n = len(Y)

# 重みの総当たり計算

for w1 in np.arange(-learning_range, learning_range + learning_rate, learning_rate):

for w2 in np.arange(-learning_range, learning_range + learning_rate, learning_rate):

for b in np.arange(-learning_range, learning_range + learning_rate, learning_rate):

# フォワードプロパゲーション

Z = np.dot(X, np.array([[w1], [w2]])) + b # 重みとバイアスを使用して予測値を計算

A = sigmoid(Z) # シグモイド活性化関数を適用

# 損失の計算

loss = (1/n) * np.sum((A - Y.reshape(-1,1))**2) # 平均二乗誤差

# 最小損失の更新

if loss < min_loss:

min_loss = loss

best_w1 = w1

best_w2 = w2

best_b = b

# ログの表示

print(f'loss: {min_loss}')

print(f'weight: w1 = {best_w1}, w2 = {best_w2}')

print(f'bias: b = {best_b}')

# 最小コストの重みを更新

W = np.array([[best_w1], [best_w2]])

b = best_b

# 学習結果の表示

print('learning completed')

print(f'weight: w1 = {W[0]}, w2 = {W[1]}')

print(f'bias: b = {b}')

# 出力結果確認

print(f'X={X}')

result = sigmoid(np.dot(X, W) + b)

print(f'hatY={result}')

# 分類境界線のプロット

x1 = np.linspace(-0.5, 1.5, 100) # x1の値の範囲

x2 = -(W[0] * x1 + b) / W[1] # x2の計算

plt.figure()

plt.scatter(X[Y == 0, 0], X[Y == 0, 1], c='r', label='Class 0', marker='o')

plt.scatter(X[Y == 1, 0], X[Y == 1, 1], c='b', label='Class 1', marker='o')

plt.plot(x1, x2, 'k', linewidth=2)

plt.xlim([-0.5, 1.5])

plt.ylim([-0.5, 1.5])

plt.title('Decision Boundary')

plt.legend()

plt.grid()

plt.show()

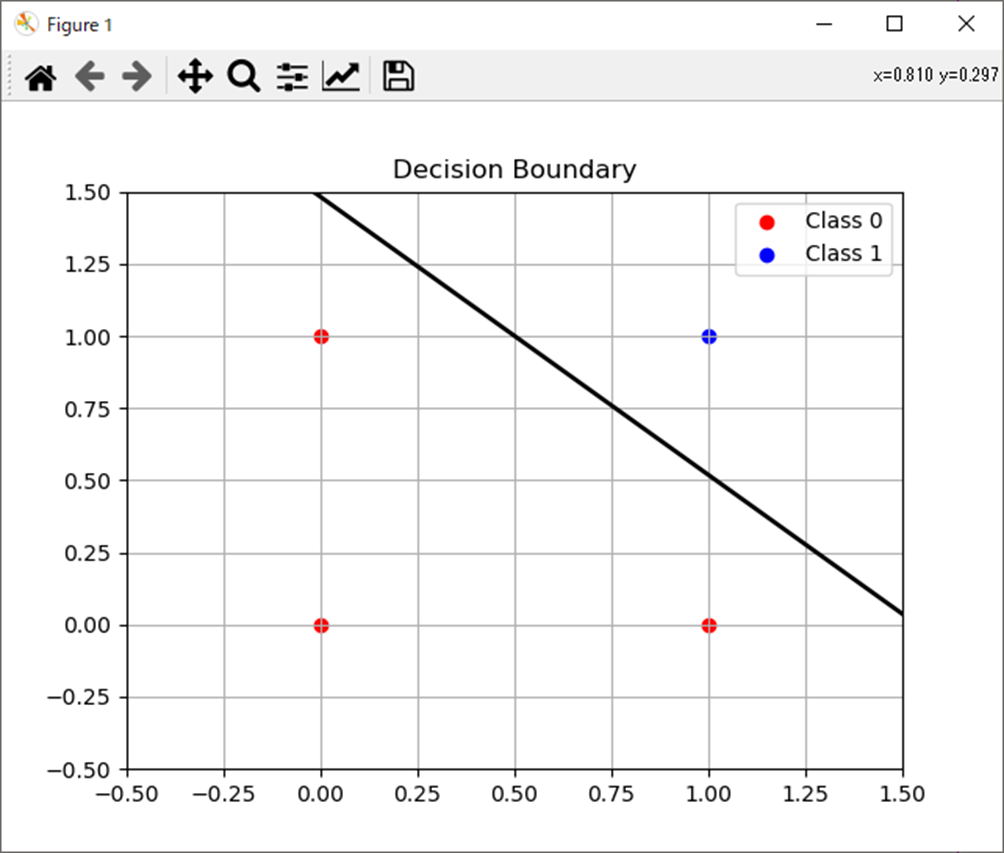

処理結果

処理結果は以下。

weight: w1 = [2.6], w2 = [2.7]

bias: b = -4.0

X=[[0. 0.]

[0. 1.]

[1. 0.]

[1. 1.]]

hatY=[[0.01798621]

[0.21416502]

[0.19781611]

[0.78583498]]

まとめ

- 活性化関数をシグモイド関数にした形式ニューロンをPython(NumPy)で実現。

- 結果はカスタムヘヴィサイドの時と一緒。

MATLAB、Python、Scilab、Julia比較ページはこちら

Pythonで動かして学ぶ!あたらしい線形代数の教科書

Amazon.co.jp

ゼロから作るDeep Learning ―Pythonで学ぶディープラーニングの理論と実装

Amazon.co.jp

ゼロからはじめるPID制御

https://amzn.to/3SvzuyR

OpenCVによる画像処理入門

https://amzn.to/498ZUgK

恋する統計学[回帰分析入門(多変量解析1)] 恋する統計学[記述統計入門]

Amazon.co.jp

Pythonによる制御工学入門

Amazon.co.jp

理工系のための数学入門 ―微分方程式・ラプラス変換・フーリエ解析

https://amzn.to/3UAunQK

コメント